Dense 3D Coordinate Code Prior Guidance for High-Fidelity Face Swapping and Face Reenactment

Abstract

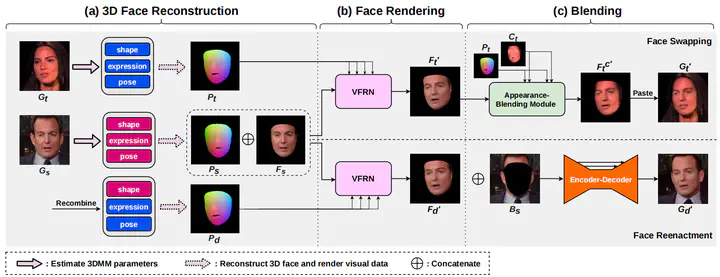

In face synthesis tasks, commonly used 2D face representations (e.g. 2D landmarks, segmentation maps, etc.) are usually sparse and discontinuous. To combat these short comings, we utilize a dense and continuous representation, named Projected Normalized Coordinate Code (PNCC), as the guidance and develop a PNCC-Spatio-Normalization (PSN) method to achieve face synthesis regarding arbitrary head poses and expressions. Based on PSN, we provide an effective framework for face reenactment and face swapping task. To ensure a harmonious and seamless face swapping, a simple yet effective Appearance-Blending Module (ABM) is proposed to fit the synthesized face to the target face. Our method is subject-agnostic and can be applied to any pair of faces without extra fine-tuning. Both qualitative and quantitative experiments are conducted to demonstrate the superiority of the proposed method in comparisons to existing state-of-the-art systems.

稠密三维坐标编码指导下的高保真人脸交换和人脸重演

摘要

在人脸合成任务中,常用的二维人脸表征(如 2D 人脸关键点,人脸分割图等)通常稀疏且不连续,进而导致无法精确指导人脸的合成。为了克服这些缺点,我们采用一个稠密且取值连续的人脸表征:Projected Normalized Coordinate Code (PNCC) [1] 作为指导,并提出一个 PNCC-Spatio-Normalization (PSN) 方法来实现任意姿态和表情的人脸合成。基于 PSN,我们设计了一个用来实现换脸和人脸重演的框架,以及一个简单有效的融合算法 Appearance-Blending Module (ABM)。我们的方法不需要额外的训练和微调,实验证明了该方法的优越性。

引言

真实感的人脸合成是计算机视觉和图形学领域的一个新兴研究课题,其中人脸交换(简称“换脸”)和人脸重演是两个很有前途的子任务。人脸交换是将源人脸的身份转移到目标人脸,而人脸重演是利用目标人脸的姿态和表情来驱动源人脸。它们由于在娱乐、隐私、虚拟现实和视频配音等方面的应用前景而受到关注。

在换脸和人脸重演任务中,2D 人脸表征(如人脸关键点,人脸分割图等)常被用作指导人脸合成的工具,然而这些表征常常由于过于稀疏而无法精确指导人脸的合成,且完全基于 2D 的表达也无法将人脸属性进行解耦(如身份,姿态,表情等属性)。也有一些在隐空间进行编码进而合成人脸的方法,这些方法虽然取得了不错的实验结果,但合成过程缺乏可控性和灵活性。

为了解决上述问题,我们提出使用一种更加稠密的人脸表征:Projected Normalized Coordinate Code (PNCC) [1] 来精确地指导人脸合成并实现人脸属性的解耦和控制。PNCC 是一种基于三维人脸重建的二维人脸表征,具有稠密和邻域取值连续的特点。在之前的工作中,PNCC 都是作为一种辅助信息来帮助合成人脸,没有充分发挥其潜能。

为了充分利用 PNCC、挖掘其表达能力,我们将 PNCC 作为人脸的唯一表征提出了一种 PNCC-Spatio-Normalization (PSN) 方法,并基于此提出了一个 Vivid-Face-Rendering-Network (VFRN) 网络,来实现任意姿态和表情下的高保真度人脸合成,该网络在换脸和人脸重演过程中都会用到。需要注意的是,在进行换脸时,VFRN 合成的人脸与目标人脸具有不同的肤色,于是我们又提出了一个简单有效的 Appearance-Blending Module (ABM) 模块来将合成人脸无缝融入目标人脸。总的来说,我们提出了一个实现换脸和重演的整体框架,充分挖掘了 PNCC 的表达能力,并进行了一系列定性和定量的实验证明其有效性。

总结本文的贡献: (1)提出了一个可以实现换脸和重演的整体框架,并取得了优秀的合成效果; (2)使用 PNCC 为唯一的人脸表征并提出 PSN 方法来实现高保真度的人脸合成; (3)提出了一个简单有效的 ABM 方法来实现不同色调的人脸之间的无缝融合。

方法

整体流程分为三个阶段:(1) 三维人脸重建;(2) 高保真人脸合成;(3) 融合。在三维人脸重建阶段,基于3DMM模型,预测出人脸形状、表情、姿态参数,并渲染出相应的 PNCC 图;对于人脸重演任务,还需要进行参数重组并渲染出相应的 PNCC 图。在高保真人脸合成阶段,通过一个具有 coarse-to-fine 结构的 VFRN 网络,在条件 PNCC 的指导下,先合成 128x128 的粗糙人脸,再合成 256x256 的富有细节的高保真人脸。最后的融合阶段,对于换脸任务,我们用 ABM 方法来实现源人脸和目标人脸的无缝融合;对于人脸重演任务,我们用一个深度网络来合成人脸的背景部分。

实验

人脸交换

将我们的方法与 FSGAN[2]、Faceshifter[4] 进行比较,可以看到,FSGAN[2] 倾向于生成过度平滑的图片,导致真实感略差;Faceshifter[4] 倾向于生成条状伪影,且有时会检测不到人脸导致换脸失败,鲁棒性下降。对比之下,我们的方法鲁棒性更强且合成结果的真实感更好。

人脸重演

将我们的方法与 FSGAN[2]、FOM[3]、Bilayer[5] 进行比较,可以看到,FSGAN[2] 倾向于生成过度平滑的图片且身份信息保留不够好;FOM[3] 在进行跨身份重演时容易生成变形的结果;Bilayer[5] 身份信息的保留没有我们的方法好。注意到这些方法大都直接采用目标人脸关键点作为主要表征来指导人脸的合成,这容易造成身份泄露的问题。而我们的方法基于三维人脸重建,将身份信息和姿态表情等属性解耦开来,从而保证不会产生身份泄露的问题。

消融实验

我们将 PNCC 换成人脸关键点图和人脸语义分割图这种稀疏表征,得到了相应的合成人脸。可以看到,基于 PNCC 这种稠密表征合成的人脸明显具有更好的视觉效果和更高的保真度。

另外,我们还将本文提出的人脸融合算法 ABM 和现有的融合算法进行了比较。

结论

在这篇文章中,我们提出了一个实现人脸交换和人脸重演的全新框架,采用 PNCC 作为人脸表征并提出了一个 PSN 方法来实现任意姿态下的高保真人脸合成,充分挖掘了 PNCC 的表征能力。另外,我们提出了一个简单有效的人脸融合算法 ABM,以实现目标人脸与背景的无缝融合。一系列主客观实验证明了我们方法的优越性。

参考文献

- [1] X. Zhu, X. Liu, Z. Lei, and S. Z. Li. Face alignment in full pose range: A 3d total solution. IEEE transactions on pattern analysis and machine intelligence, 2017.

- [2] Y. Nirkin, Y. Keller, and T. Hassner. Fsgan: Subject agnostic face swapping and reenactment. In Proceedings of the IEEE international conference on computer vision, pages 7184–7193, 2019.

- [3] A. Siarohin, S. Lathuiliere, S. Tulyakov, E. Ricci, and N. Sebe. First order motion model for image animation. In Conference on Neural Information Processing Systems (NeurIPS), December 2019.

- [4] L. Li, J. Bao, H. Yang, D. Chen, and F. Wen. Faceshifter: Towards high fidelity and occlusion aware face swapping. 12 2019.

- [5] E. Zakharov, A. Ivakhnenko, A. Shysheya, and V. Lempitsky. Fast bi-layer neural synthesis of one-shot realistic head avatars. In ECCV, August 2020.